| 后台-系统设置-扩展变量-手机广告位-内容正文顶部 |

AI正深刻驱动着各领域的创新浪潮。借助AI的力量,各行各业能够显著提升运营效率、降低成本并塑造超高生产力的未来工作模式。不过,AI系统的成功部署与高效运行,其核心支撑在于底层基础设施——它往往是AI技术栈中最易被低估,却又最为关键的一环。特别是随着DeepSeek等生成式AI模型的崛起及其应用的普及,AI工作负载变得更加多样和复合化,这要求基础设施的战略定位更加清晰、更具落地性。

在刚刚举办的AMD Advancing AI 2025大会期间,AMD发布了全面的端到端AI平台愿景,并展示了全新的开放、可扩展的人工智能基础设施产品。其中,EPYC对AMD未来的AI愿景具有非常重要的意义。

18倍增长,EPYC的AI进阶之路!

EPYC堪称AMD历史上最成功的产品系列之一,经历了数代产品的相继更迭,EPYC将“CPU的AI进化之路”展现在业界面前。

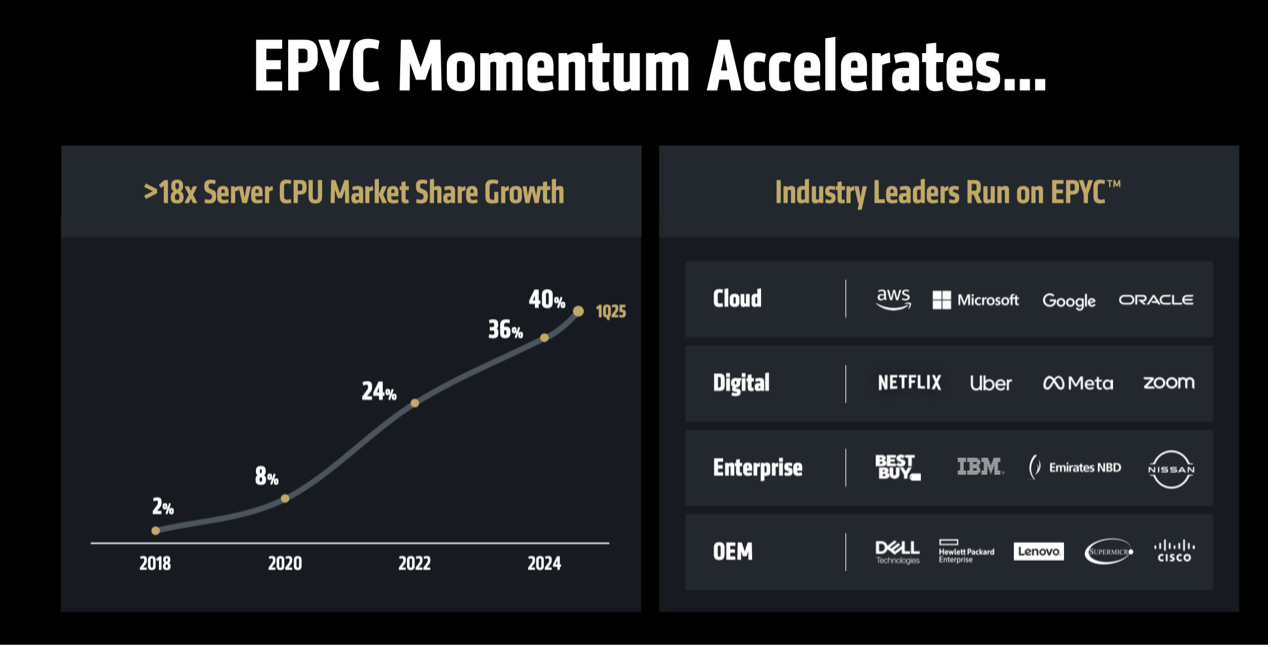

根据AMD分享的 EPYC处理器市场份额的增长情况,从2018年2%到2024年36%,实现了18倍的飙升——四年间从边缘玩家跃居行业核心,占据约三分之一市场份额,这种增幅在寡头垄断的服务器芯片市场堪称奇迹。头部客户名单覆盖了云服务巨头、数字企业、企业和OEM厂商,进一步佐证了市场份额的坚实有力。

回顾EPYC的开疆拓土,特别是在AI领域的发展,可以说第四、第五代EPYC以通用计算重塑推理效能,对AI发展和AMD自身的产品迭代都具有重要的意义。面对复合型AI负载的挑战,AMD第四代、第五代EPYC处理器展现了出色的适应性与效率,成为构建务实AI基础设施的理想选择。

具体而言,第四代EPYC能够在AI推理方面脱颖而出,主要得益于其先进的架构和创新的设计。基于Zen 4架构的AMD EPYC处理器“Genoa”,采用了先进的5nm工艺,最多可达到96核心192线程,配备了12通道DDR5内存和160条PCIe 5.0总线。更大的内存总线,可以令更多数据在内存中进行快速加载,从而有效减少因数据传输而造成的时延;更多的PCIe总线意味着在单台服务器上可以接入更多AI计算板卡,能够提供更高密度的AI算力。

值得一提的是,第四代AMD EPYC处理器还引入了对AI/ML应用程序至关重要的DDR5内存和第五代PCIe,还有3D V-Cache技术的加持,进一步增强了第四代AMD EPYC处理器的多任务处理能力,并有效降低了延迟。

正是凭借这种高并发核心设计,AMD第四代EPYC全面覆盖了碎片化的推理场景,成为AI推理服务器的主流选择。特别是在金融风控、工业设备诊断等众多场景,通过极致能效和专用指令集与架构优化,凸显了高并发处理能力,为用户提供了良好体验。

如果说第四代EPYC为AI大模型推理应用奠定了坚实的基础,那么第五代EPYC则进一步实现飞跃,能够帮助用户实现更高效的推理,更充分地满足各类AI工作负载的需求,并适应不同模型大小。

第五代EPYC基于Zen 5架构,对AI的支撑能力更上一层楼。相比Zen 4,Zen 5核心架构不仅提供多达17%的更高每时钟指令数(IPC),还能为AI和HPC提供高达37%的更高IPC,从而提升了AI部署的洞察时间和部署速度。比如,192核的EPYC可为端到端AI工作负载提供更高的性能,在Meta Llama 3.1-8B的中小型企业级生成式AI模型中,其吞吐量性能具有显著优势。

20倍能效新目标,AMD EPYC提供核芯动力

在Advancing AI 2025上,AMD宣布已经超越了在2021年制定的30x25目标:即从2020年到2025年将AI训练和高性能计算(HPC)节点的能效提高30倍。

这意味着,与过去五年(2015-2020年)的行业趋势相比,能效提升2.5倍以上。截至 2025 年中,AMD已超越这一目标,正是通过AMD GPU和第五代AMD EPYC CPU的配置,相较基准系统实现38倍的能效提升。与五年前的系统相比,这相当于在相同性能下能耗降低97%。

下一步,随着人工智能规模的不断扩大,以及迈向真正的端到端的全AI系统设计,AMD比以往任何时候都更需要继续保持在节能设计领域的领先地位。

AMD高级副总裁兼企业院士Samuel Naffziger指出,AMD将目光投向一个大胆的新目标:以2024年为基准,到2030年,将用于AI训练和推理的机架级能效提升20倍,使目前需要超过275个机架的典型AI模型到2030年只需在一个机架内即可完成训练,耗电量减少95%。而结合软件和算法方面的进步,新的目标可使整体能效提升高达100倍。

根据AMD最新的设计和路线图预测,这反映了整个机架的每瓦性能提升,包括 CPU、GPU、内存、网络、存储和软硬件协同设计。这种从节点到机架的转变,其实得益于AMD快速发展的端到端AI战略,也是以更可持续的方式扩展数据中心AI的关键。

Samuel Naffziger强调,随着工作负载规模和需求的持续增长,节点级效率提升将无法跟上步伐,最显著的效率影响可以在系统级实现,而这正是AMD 2030年目标的重点,也是AMD在AI时代的新目标。

EPYC助力构建高效、灵活的未来AI基础设施

构建AI基础设施没有放之四海皆准的方案,过度依赖昂贵的专用加速器(如某些GPU)可能导致投资浪费和利用率低下,尤其当许多AI任务(特别是中小型推理负载或嵌入业务流的功能)完全能在强大的CPU上高效运行时,对于能源、效率、成本都是巨大的节约。

这些都与AMD EPYC 处理器的价值主张相契合,放眼未来,在AMD机架级的能效目标中,新一代以及未来几代EPYC将继续保持能效比(性能/瓦特)优势,助力降低数据中心能耗,实现更绿色、高密度的计算解决方案。

至于企业如何规划、部署未来的AI基础设施?IDC给出的建议是:第一,通过替换过时服务器在数据中心腾出空间,因为长远来看,改造过时服务器成本高昂,而新的服务器通常不仅能力更强,而且通常效率更高;第二,采用私有或混合云策略处理虚拟化、容器化和裸机工作负载,这有助于确保每个 AI 工作负载都匹配到合适的基础设施堆栈;第三,通过选择合适类型的处理器 (CPU) 优化协处理器(加速器)投资,可以避免加速器资源利用不足或利用不均的情况。

正因具备强大的通用处理能力、领先的能效比以及对AI加速的优化支持,AMD EPYC处理器能够高效驱动DeepSeek等大模型的推理负载, 助力企业在无需大规模新建基础设施的前提下,高效、灵活地拥抱以DeepSeek等模型为代表的生成式AI趋势,最大化AI投资价值。

内容转载自:与非网